KI, schreib das fertig!

KI-gestützte Texterstellung könnte die Hürden traditioneller Textproduktion durch Automatisierung und iterative Verbesserung regelrecht durch die Decke gehen lassen ... wenn wir uns dieses digitalen Geschenks auf einigen Ebenen ganzheitlich bewusst werden. Davon handelt dieser kleiner Fachbeitrag, den es früher als Kurs bzw. Seminar bei mir gab.

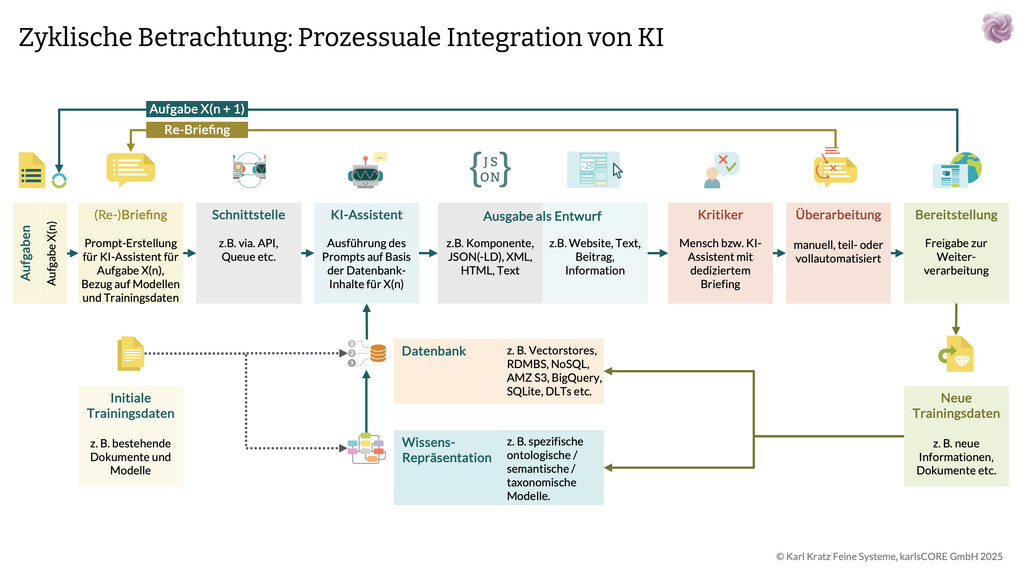

In diesem einfachen Modell kombiniere ich im Groben fünf Komponenten: Die Auftragsklärung, technische Schnittstellen, KI-Assistenz, systematische Qualitätskontrolle und teilautomatisierte Überarbeitung.

Der Grund, warum das wichtig ist: In vielen Unternehmen endet die Texterstellung nach der ersten Korrektur. KI macht nun das möglich, was früher zu aufwändig war - kontinuierliche Verbesserung. Doch viele Unternehmen nutzen KI falsch, behandeln sie wie bessere Freelance-Texter. Das Ergebnis: generische, austauschbare Texte.

Die Lösung liegt im systematischen Ansatz. Statt "Briefing rein, Text raus" braucht es einen geschlossenen Kreislauf. Jede der fünf Komponenten hat dabei eine spezifische Aufgabe: Menschen entwickeln die Strategie und treffen kreative Entscheidungen, KI übernimmt die operative Umsetzung und erstellt Varianten in Rekordgeschwindigkeit.

Was ich in der Praxis beobachte: Die erfolgreichsten Implementierungen behandeln KI als lernfähiges System, nicht als Werkzeug. Der entscheidende Unterschied liegt in der Feedback-Schleife. Während traditionelle Prozesse linear ablaufen, ermöglicht KI einen kybernetischen Ansatz - das System lernt aus jedem Durchgang und wird besser.

Das Diagramm zeigt genau diesen Paradigmenwechsel. Der geschlossene Kreislauf aus Auftragsklärung, Texterstellung, Bewertung und Überarbeitung war in der Theorie schon immer richtig. In der Praxis scheiterte er an Zeit und Kosten. Mit teilautomatisierter Überarbeitung wird aus der theoretischen Idealvorstellung plötzlich gelebte Realität.

Warum die "Content-Pflege" vielleicht oft nicht so gut geklappt hat »

1.1 Warum viele Content-Prozesse oft gescheitert sind

Iterative Inhaltserstellung scheiterte bisher am Missverhältnis zwischen Aufwand und Nutzen. Obwohl sehr viele Menschen wissen, dass Texte durch Überarbeitung besser werden, endete der Prozess meist nach der ersten Korrektur: Vordergründig zu teuer, zu zeitaufwändig, zu komplex.

KI verändert diese Gleichung jetzt fundamental: Was früher Wochen dauerte, geht jetzt in Minuten. Überarbeitung wird von der Ausnahme zur Regel.

Aber damit merkt man dann auch, dass das strukturelle Problem tiefer liegt. Ein typischer Texterstellungsprozess folgt meist dem Wasserfallprinzip: Briefing, Erstellung, Korrektur, Veröffentlichung. Fertig. Die Deadline diktiert das Ende, nicht die Qualität. Jeder weitere Durchgang kostet Zeit und Geld (aka "Ressourcen, die meist nicht eingeplant sind").

Echte Optimierung braucht aber genau das: Mehrere Iterationen. Ein Text will auf Resonanz getestet werden, die Leistung gemessen, Schwachstellen identifiziert, überarbeitet, wieder getestet. In der analogen Welt bedeutete jeder Schritt Koordination zwischen Menschen, Wartezeiten, Abstimmungsrunden. Die Transaktionskosten haben früher tatsächlich oft den potenziellen Nutzen aufgefuttert, vor allem wenn noch nicht viel Erfahrung da war.

Durch die Verfügbarkeit von KI fällt diese Limitierung jetzt augenscheinlich weg: Automatisierung senkt die Transaktionskosten gegen Null (Spoiler: Nein.) Was früher eine Woche Ping-Pong zwischen Texter und Auftraggeber war, erledigt KI in einer Stunde. Plötzlich wird kontinuierliche Verbesserung wirtschaftlich sinnvoll. Der Paradigmenwechsel in den Hochglanz-Powerpoints lautet schon: Nicht mehr "gut genug für den Launch", sondern "immer besser durch Daten".

Aber: Wer je versucht hat, Menschen für datengetriebene Entscheidungen zu begeistern, kennt die "Landkarte aller Widerstände".

In diesem Kontext möchte ich Dir zwei Menschen empfehlen, die einen sauguten Blick auf das Thema "Daten" haben:

Nimm die zwei einfach mal bei LinkedIn dazu ... da kommen immer wieder interessante Impulse.

Die Geschichte der gescheiterten Iterationen ist eine Geschichte der falschen Anreize: Agenturen werden für abgeschlossene Projekte bezahlt, nicht für kontinuierliche Verbesserung (obwohl das eigentlich ein deutlich wirksamerer Umgang miteinander wäre). Interne Teams haben andere Prioritäten, sobald ein Text "fertig" ist. Die Organisation ist auf Abschluss ausgerichtet, nicht auf Evolution.

Dazu kommt die psychologische Komponente. Nach drei Korrekturschleifen sind alle Beteiligten erschöpft. Der Text ist "gut genug", die Energie für weitere Verbesserungen fehlt. Man kennt das Phänomen aus der Softwareentwicklung: Die technischen Schulden häufen sich an, weil der Druck für neue Features größer ist als der für Refactoring.

Ein weiteres Hindernis war meist die fehlende Messbarkeit: Wie quantifiziert man die Verbesserung eines Textes? Ohne klare Metriken wird Optimierung zur Geschmacksfrage. Diskussionen drehen sich im Kreis, objektive Entscheidungsgrundlagen fehlen. Die Folge: Man einigt sich auf den kleinsten gemeinsamen Nenner.

Das war übrigens mit ein Grund, weshalb ich damals in karlsCORE das Tool "Content Score" eingeführt habe: Damit Menschen qualifizierte multi-optionale und multi-faktorielle Entscheidungen treffen können - und zum Beispiel auf dieser Basis direkt sehen: "Welche Text-Verbesserungen tragen mit einer hohen Wahrscheinlichkeit zu einer Verbesserung der Wertschöpfung im Unternehmen bei?"

Die technischen Limitierungen verstärkten das Problem: Varianten-Tests waren aufwändig einzurichten. A/B-Testing für Texte erforderte Entwicklerressourcen. Die Analyse der Ergebnisse brauchte statistisches Know-how. Für die meisten Unternehmen war der Aufwand zu viel.

Auch die "Skill-Gap" spielte eine Rolle. Gute Texter sind selten auch gute Datenanalysten (haha, keine Sorge - das gilt auch umgekehrt!). Die Trennung zwischen Kreation und Analyse führte zu Informationsverlusten. Erkenntnisse aus Tests flossen nur gefiltert zurück in die Texterstellung. Der Lerneffekt verpuffte regelmäßig.

"Mit KI ändert sich all das!"

Die Maschine kennt keine Ermüdung, keine Deadline-Panik, keine Befindlichkeiten. Sie iteriert geduldig, bis die Metriken stimmen. Die Integration von Erstellung, Testing und Analyse in einem System schließt die Feedback-Schleife. Was früher ein frommer Wunsch war, wird zur neuen Normalität: Texte, die sich selbst optimieren.

Hinweis: Glaube bitte nicht alles, was in grünen Kästen steht. In der Praxis gilt: Wenn eine Sache nie ermüdet, dann nimmt das Umfeld daran regelmäßig schaden.

"Unermüdlichkeit" ist eine Totalabsage an jegliche Lebendigkeit. Ich habe allein in den letzten 3 Jahren so viele Menschen getroffen, die von dem Einfall des ASCII-Terminators erschöpft und ausgebrannt sind. Und ich denke, dass wir hier noch viel Nach- und vor allem Vordenken müssen.

1.2 Die fünf Komponenten, die zusammenspielen müssen

Prozesse mit KI-Systemen für die Text-Erstellung und -Optimierung funktionieren nur, wenn alle Teile ineinandergreifen. Ich habe es oft erlebt, dass Unternehmen einzelne KI-Tools einsetzen, aber die Prozesskette nicht durchdenken. Dann wird zwar schneller geschrieben, aber die Qualität bleibt mittelmäßig ... und die Menschen sind nach einer Weile eschöpft und müde.

(Kontinuierlich erneute) Auftragsklärung und Nachbesprechung: Das ist Deine Stellschraube. Niedrigkomplex gilt erstmal: "Je präziser Du der KI sagst, was Du willst, desto besser wird das Ergebnis." Aber hier liegt schon das erste Problem: Die meisten Briefings sind viel zu ungenau. "Schreibe einen Text über unser Produkt" reicht nicht. Die KI braucht Kontext, Zielgruppe, Tonalität, gewünschte Wirkung, trallala, Zeug (viele winken hier schon ab: "Ja, weiss ich ja alles, das sind Basics!").

Warum ein präziseres Briefing nicht automatisch bessere Ergebnisse liefert

- Mikro-Management oder Problem der Überbestimmung: Zu detaillierte Vorgaben zwängen die KI in ein enges Korsett. Sie folgt dann mechanisch deiner Struktur, statt ihre Stärken auszuspielen. Die KI kann oft elegantere Lösungswege finden, wenn Du ihr Raum dafür lässt.

- Kontext schlägt Kleinteiligkeit: Ein kurzer Prompt mit dem richtigen Kontext ("Erkläre das einem müden Manager/ Teenager") funktioniert oft besser als seitenlange Anweisungen mit 50 Einzelvorgaben. Viele KI-Systeme verstehen implizite Anforderungen erstaunlich gut.

- Der Sweet Spot der Anweisung: Definiere klar das gewünschte Ergebnis und den Kontext, aber lass Spielraum bei der Umsetzung. Sage WAS Du erreichen willst, nicht WIE jeder einzelne Schritt aussehen soll.

- Iteratives Vorgehen schlägt Perfektion: Statt einer vermeintlich perfekten Mega-Anweisung funktioniert Dialog besser. Starte simpel, schaue dir das Ergebnis an, verfeinere gezielt. Die KI lernt aus der Konversation, was Dir wichtig ist.

- Überfrachtung führt zu Konflikten: Je mehr Bedingungen Du stellst, desto wahrscheinlicher widersprechen sie sich. Die KI muss dann Prioritäten erraten. Beispiel: "Sei kreativ, aber halte dich exakt an diese Struktur" – was gilt nun?

- Praktisches Beispiel: "Schreibe eine Pressemitteilung über unsere neue Software" plus 2-3 Kernpunkte funktioniert meist besser als eine dreiseitige Formatvorlage mit exakten Wortanzahlen pro Absatz. Die Kunst liegt darin, resonanzfähige Kernpunkte zu entwickeln; z. B. Ereignisse der Bedarfsgruppe.

- Pareto ist unser Freund: Die 80/20-Regel gilt auch hier; 80% des Ergebnisses erreichst Du mit 20% der möglichen Instruktionen. Der Rest ist oft kontraproduktiv. (Ich hantiere oft eher mit der 98/2-Regel ...)

Schnittstellen und Datenbank-Anbindung: Das ist der technische Unterbau. CMS-Anbindung, Styleguides, Referenz-Texte. Klingt trocken, ist aber entscheidend. Wenn die KI Zugriff auf Deine besten Texte (Achtung: In Form einer bestimmten Aufbereitung!) hat, kann sie die Inhalte lernen und für neue Aufgaben übernehmen.

KI-Text-Assistent: Das Arbeitstier (auch liebevoll "Der Rechenknecht"). Aber auch hier gibt's oft Denkfehler. KI ist kein Zauberwerkzeug, das aus schlechten Briefings gute Texte macht. Shit in = Shit out gilt auch hier.

Kritiker-Funktion: Die Qualitätskontrolle. Die kann technisch oder menschlich sein, wichtig ist: Es muss systematisch und konsequent passieren, nicht nur sporadisch nach Bauchgefühl oder wenn Zeit ist (es ist nie Zeit ;-) ).

Überarbeitung: Hier wird es spannend. Teilautomatisiert ist oft der beste Weg. KI macht den ersten Überarbeitungsvorschlag, Mensch entscheidet, schreibt, reichert an. So kombinierst Du Geschwindigkeit mit menschlicher Qualität. Auch wenn vieles plausibel erscheint, was KI-Systeme uns zusammenhalluzinieren (ich spreche dabei gerne von "stochastischer Papagei auf LSD"): Die meiste Erfahrung, die KI-Systeme eben NICHT zusammenscrapen konnten, stecken nach wie vor in menschlichen Köpfen.

1.3 Was Menschen machen, was KI macht

Das -aus meiner persönlichen Sicht- größte Missverständnis, seit es automatisiert erstelle Texte gibt: "KI soll Texter ersetzen". Meine Erfahrung ist eine deutlich andere, auch wenn es sich in der Welt vielleicht gerade danach anfühlt. Die besten Ergebnisse entstehen, wenn Menschen und KI zusammenarbeiten, nicht wenn KI alleine werkelt.

Es kann hilfreich sein, wenn man KI nicht als Gegner oder Ersatz betrachtet, sondern als Komplementär.

Menschen können solche Sachen gut:

- Strategien entwickeln

- Zielgruppen verstehen

- Kreative Entscheidungen treffen

- Emotionen einschätzen

KI ist gut in:

- Erbarmungslos schneller Umsetzung (egal ob funktional oder nicht ...)

- Varianten erstellen

- Muster erkennen

- Wiederholungen automatisieren ...

In der Praxis bedeutet das: Du entwickelst die Inhaltsstrategie, die KI setzt sie um. Du bewertest die Ergebnisse, die KI überarbeitet sie. Du triffst die kreativen Entscheidungen, die KI macht die operative Arbeit.

Was ich dabei gelernt habe: Je klarer die Aufgabenteilung, desto besser die Ergebnisse. Versuche nicht, der KI strategische Entscheidungen zu überlassen. Aber lass sie auch nicht zum stumpfen ASCII-Knecht verkommen.

1.4 Ein anderer Blick auf das Thema

Bisher war Texterstellung ein linearer Ablauf: Ein Projekt mit Anfang und Ende. Briefing, Schreiben, Korrektur, Veröffentlichung, fertig.

KI-gestützte Texterstellung ist dagegen eher ein Regelkreis. Die Texte entwickeln sich weiter, werden laufend angepasst, optimiert.

Das erfordert eine andere Denkweise. Du planst nicht mehr einzelne Text-Projekte, sondern "Inhaltssysteme".

Dieser Text, den Du hier liest, ist zum Beispiel gar kein "Text": Dahinter steckt ein aufwendiges, dynamisches System, das ...

- den Text auf der Basis von Daten und Regeln an bestimmten Stellen (z. B. in anderen Texten, in Übersichtsseiten) anzeigt (oder auch nicht),

- bestimmte Inhalte anzeigt oder ausblendet, die Länge, Intensität, Intention regelt,

- beobachtet / misst, wie mit diesem Text im Lauf der Zeit umgegangen wird bzw. welche Resonanz er erzeugt.

Aus einer systemischen und kybernetischen Sicht verschiebt sich der Fokus von "es soll ranken und konvertieren" hin zu: Du misst, ob der Text multiple, zyklische Ziele erfüllt; daran orientiert sich die Struktur um den Text und die Struktur innerhalb des Textes.

Ein Beispiel aus der Praxis: Früher hast Du eine Produktbeschreibung geschrieben und sie jahrelang verwendet. Mit KI erstellst Du verschiedene Versionen für verschiedene Bedarsgruppen, testest sie gegeneinander, optimierst die erfolgreichen weiter. Der Text wird vom statischen Baustein zum dynamischen Werkzeug.

Das bedeutet auch: Du brauchst andere Erfolgskennzahlen. Also nicht nur "Ist der Text fehlerlos?", sondern "Erzeugt er eine bestimmte Art von Konversionen?", "Erzeugt er Resonanz mit der Bedarfsgruppe?", "Verstärkt er die Marke?".

Mit guten KI-unterstützten Prozessen bekommen es Unternehmen ganz gut hin, den Fokus ihrer Fragen zu höherdimensionalen Metriken zu verschieben (gottseidank, endlich!).

2. Die Auftragsklärung: Grundlage für gute Texte

Hier entscheidet sich alles. Ein schlechtes Briefing führt zu schlechten Texten, egal wie gut die KI ist. Das Problem: Die meisten Briefings sind ... haben Luft nach oben. "Schreibe einen Text über Produkt X" oder "Erzeuge die Inhalte für die Landingpage". Damit kann keine KI arbeiten, und ehrlich gesagt, Menschen auch nicht wirklich (die saugen sich dann was aus den Fingern. Die KI braucht wenigstens keine Pillen für eine ordentliche Halluzination).

Was ich immer wieder erlebe: Unternehmen investieren Tausende in KI-Tools, aber vernachlässigen das Briefing. Dann wundern sie sich, warum die Ergebnisse generisch sind. KI ist wie ein sehr fähiger, aber pedantischer Mitarbeiter. Sie macht genau das, was Du sagst. Wenn Du ungenau bist, wird sie es auch.

Die gute Nachricht: Ein gutes Briefing für KI-Systeme zu schreiben ist erlernbar. Es folgt klaren Regeln und wird mit der Zeit zur Routine. Und der Aufwand lohnt sich, weil ein einmal entwickeltes Briefing für viele ähnliche Texte wiederverwendet werden kann.

Warum kommt hier kein Beispiel für ein Briefing?

Warum kommt hier kein Beispiel für ein Briefing?

Weil es sinnlos wäre - und Zeitvergeudung. ;-)

(Mehr dazu weiter unten.)

2.1 Warum die meisten Briefings scheitern

Das typische Briefing klingt so: "Wir brauchen einen Text für die neue Produktseite. Zielgruppe sind Unternehmen. Soll professionell klingen, aber nicht zu trocken. Etwa 300 Wörter." Fertig. Damit kann niemand arbeiten.

Was fehlt? Zum Beispiel:

- Welche Unternehmen? Was haben sie alle gemeinsam?

- Was ist deren teuerstes Problem?

- Warum sollten sie sich für Dein Angebot interessieren?

- Welche Einwände haben sie?

- Was sollen sie nach dem Lesen tun?

- In welchem Kontext lesen sie den Text?

- Und der Klassiker aus dem Bedarfsgruppen-Modell: "Welches Ereignis erzeugt das Problem, dessen Lösung Dein Angebot ist?

Now we talk: Vor allem wenn man den letzten Punkt lange genug tief durchdenkt, entsteht die kostbarste Währung im WWW: Unterschiedlichkeit.

Meine Erfahrung: Je spezifischer das Briefing, desto besser der Text. "Unternehmen mit 50 bis 200 Mitarbeitern, die gerade ihre erste Compliance-Krise hatten und jetzt nach systematischen Lösungen suchen" ist ein brauchbares Briefing. "Unternehmen" ist keins.

Das Problem liegt oft tiefer: Viele Unternehmen kennen ihre Zielgruppe selbst nicht genau genug, von der eigentlich interessanten Bedarfsgruppe ganz zu schweigen. Das Briefing wird zum Spiegel der eigenen Unklarheit. KI kann diese Unklarheit nicht magisch auflösen, aber sie kann helfen, sie sichtbar zu machen.

2.2 Nachbriefing als systematischer Lernprozess

Hier wird es interessant. In der klassischen Texterstellung war die Nachbesprechung meist frustrierend. "Das ist nicht das, was ich wollte." "Aber das stand so im Briefing." "Ja, aber ich dachte, das sei klar." Endlose Diskussionen, verbrannte Budgets, schlechte Stimmung.

Apropos: Zum Thema "Klarheit" hat Konrad Gühlstorf einen schönen (interaktiven) Beitrag erstellt. Wer sich das mal genau anschaut, stellt dabei fest, dass das deutlich mehr als "nur ein Text" ist. Auch hier gibt es eine prozessuale Integration von KI, nur eben auf ganz anderen Ebenen.

Mit KI wird das Nachbriefing zu einem systematischen Lernprozess. Die KI ist ja nicht beleidigt, wenn Du sagst, dass der Text nicht passt. Sie fragt nicht nach, "ob das wirklich nötig ist". Und vor allem: Jede Kritik führt automatisch zu einer Überarbeitung des Briefings selbst.

(Notiz an mich: #todo Bild "Ego ist teuer" einfügen.)

Was ich seit je her erlebe: Die ersten drei bis fünf Durchläufe mit einer neuen KI sind Investitionen. Du bringst der KI bei, wie Du arbeitest, was Dir wichtig ist, welchen Stil Du bevorzugst. Auf der Basis dieser Rückmeldungen verändert sich die Ausgabe des KI-Systems meist auf eine funktionale, gewünschte Weise.

Der entscheidende Punkt: Nach jeder Kritik folgt automatisch ein Nachbriefing. Das ist kein optionaler "Tipp", sondern ein fester Prozessschritt. Der Kritiker erstellt grundsätzlich eine Überarbeitung des ursprünglichen Briefings und sei es nur: "Das war ok, keine Änderungen." Aber grundsätzlich ist das ein prozessualer Akt. Das Briefing wird dadurch systematisch weiterentwickelt.

In der Praxis bedeutet das: Jeder Textauftrag macht nicht nur den Text besser, sondern auch das Briefing-System. "Beim nächsten Mal mehr Emotionen", "Weniger Fachbegriffe", "Stärkerer Handlungsaufruf". Diese Erkenntnisse fließen direkt in die Briefing-Vorlage ein. Das System lernt also kontinuierlich, bessere Aufträge zu formulieren.

Konkrete Implementierung

In vielen Projekten setze ich die prozessuale Integration der KI so ein:

- Alle verfügbaren Trainingsdaten werden in maschinenlesbare Formate gebracht.

- Aus diesen Trainingsdaten werden sogenannte semantische und ontologische Modelle entwickelt. Das ist das "Kernstück" jeglicher späterer Unterschiedlichkeit in allen weiteren Inhalts-Erstellungen. Hier ist der größte Hebel für z. B. die strategische Suchmaschinen-Optimierung und Brand-Merkmale.

- Mit den Trainingsdaten wird der Vector-Store des KI-Systems angereichert.

- Dann erstelle ich unterschiedliche Briefing-Templates für die Aufgabe(n): Strukturell, Inhaltlich usw.

- Der Prozess wird oft so gestaltet, dass das Briefing aus dem strukturellen + inhaltlichen Briefing besteht und das Re-Briefing der nächsten Feedback-Schleife additiv dazu kommt.

- In vielen Projekten arbeite ich paarweise mit KI-Systemen, d.h. es entstehen grundsätzlich zwei Inhalte, die gegen eine Reihe gewichteter Faktoren bewertet werden.

- Das Ergebnis aus dem jeweiligen KI-System wird überarbeitet. Dann wird die Differenz gemeinsam mit der KI-Ausgabe, dem Prompt und dem erzeugten Scoring in eine JSON-Datei verpackt und in den Vector-Store bzw. ins Re-Briefing übermittelt.

- Das hat weitere Vorteile: Das KI-System bekommt ein quantitatives Feedback darüber, welche Formulierungen funktional bzw. dysfunktional sind. Gleichzeitig wird der Vector-Store mit weiteren, individuellen bzw. unternehmensspezifischen Inhalten angereichert.

- Der erstellte Inhalt wird veröffentlicht und im Rahmen des Monitorings können die normalisierten Metriken über die Zeit zusätzlich als strukturierte Information zum Vector-Store hinzugefügt werden. Das ermöglicht spätere Differenzierungen wie "Optimiere den Text auf Verkäufe/ Reichweite/ Resonanz" etc.

- Nach dem Feedback ist vor dem nächsten Text: Selbst nach nur wenigen Iterationen ist bereits mit erheblich besseren Inhalten zu rechnen - die Lernkurve ist in der Regel recht steil.

2.3 Eingabe-Gestaltung für Text-KI

KI versteht Kontext, aber sie errät ihn nicht. Du musst ihr sagen, wer die Bedarfsgruppe ist, in welcher Situation/ in welchem Kontext sie den Text liest, was sie vorher gedacht oder gemacht hat, was danach passieren soll. Je mehr Kontext, desto besser der Text. Aber: Don't overdo.

Ein Beispiel: "Schreibe einen Text für eine Produktseite" vs. "Erstelle einen erkenntnisreichen Text für eine Person aus einem mittelständischer Unternehmen, die gerade ein Anwaltsschreiben zum Stichpunkt "Verstoß gegen Art. 6 Abs. 1 DSGVO" erhalten hat. Verwende das Komponenten-Modell und beginne mit einer empathischen Einleitung sowie einem interaktiven Dialog-Element, das den Kontext validiert. etc."

Marken-Tonalität ist ein weiterer kritischer Punkt (Praxis-Tipp: Die Tonalität Deiner Marke kannst Du insbesondere über semantische/ ontologische Modelle steuern). "Professionell, aber nicht zu trocken" hilft nicht. Besser: "Wie ein erfahrener Experte für Didaktik, der komplexe Themen anschlussfähig erklärt: Zugewandt, freundlich, verständnisvoll für die Sorgen der Kunden; Auf der Ebene des Ereignisses mit Erklärungen für ein 10jähriges Kind. Auf der sonstigen Sachebene mit Beschreibungen für eine erwachsene Person." Oder noch besser: Referenz-Texte mitgeben, die den gewünschten Stil exemplarisch zeigen. Praxis-Tipp Ich nutze dafür in der Regel Markup-Dateien mit integriertem JSON.

Styleguides und Markenrichtlinien werden bei KI-Texterstellung plötzlich wichtig. Was früher nur große Konzerne hatten, braucht jetzt jedes Unternehmen, das professionelle KI-Texte will. Die gute Nachricht: KI kann beim Erstellen dieser Richtlinien helfen.

Aber warum wird das so wichtig? Ganz einfach: Weil die Einzigartigkeit der Atmosphäre und Stimmung, die durch Deine Kommunikation entsteht, die maßgebliche Unterscheidung im Aussen entsteht. Und damit für Menschen, Suchmaschinen, andere KI-Systeme.

Während ich das schreibe, kommt mir der Gedanke:

"Digitaler Stallgeruch".

3. Schnittstellen-Verwaltung für Inhaltssysteme

Hier wird es technisch, aber keine Sorge. Es ist weniger kompliziert als es aussieht. Die Schnittstellen sind das Nervensystem Deines KI-Text-Systems. Sie sorgen dafür, dass alles reibungslos zusammenarbeitet: Dein CMS, die KI, die Datenbanken, die Qualitätskontrolle.

WIE das dann aussieht, ist so individuell wie Unternehmen und ihre Anforderungen:

Manche orchestrieren die Prozesse mit make, n8n (siehe auch: LowCode oder FullCode? Ein interaktives Entscheidungs-Werkzeug). Andere schreiben sich ein Python-Script dafür. Wieder andere setzen auf integrierte Komplettlösungen, massgeschneidert oder von der Stange.

Was ich oft erlebe: Unternehmen kaufen ein KI-Tool, probieren es aus, sind begeistert. Und dann kommt die Ernüchterung: Wie bekomme ich die Texte in meine Website? Wie halte ich mein Design bei? Wie integriere ich das in meinen bestehenden Arbeitsablauf? Plötzlich wird aus dem schnellen KI-Text ein manueller Kopier-und-Einfügen-Marathon und die Mitarbeitenden degradieren sich zu Copy-Paste-Robotern. Das muss ja nicht sein. :-)

Die Lösung sind durchdachte Schnittstellen. Einmal richtig aufgesetzt, arbeitet das System in seinem Rahmen weitgehend (teil-)automatisch. Der Text wird erstellt, formatiert, in das richtige System eingepflegt, überarbeitet, mit Feedback versehen, veröffentlicht, die Feedbackdaten kontinuierlich zurückgespielt.

3.1 CMS-Einbindung und Inhalts-Warteschlangen

Dein CMS ist vielleicht WordPress, Drupal, Typo3 oder ein anderes System. Die gute Nachricht: Alle modernen CMS haben Schnittstellen, über die KI-Systeme Inhalte direkt einpflegen können. Die schlechte Nachricht: Diese Schnittstellen müssen erst mal richtig konfiguriert werden.

Wer ohnehin gerade über einen obligatorischen Relaunch nachdenkt, der könnte sich mit dem Thema "headless cms" beschäftigen. Dann das wird vermutlich das sein, wo die Reise erstmal hingeht.

Blick hinter die Kulissen

Das System unter karlkratz.de wurde als "API-first" entwickelt, d.h. alles, was man machen kann, macht man über Schnittstellen:

- Neue Seiten & Meta-Informationen erstellen, bearbeiten, erweitern, löschen

- Dynamische Inhalte und interaktive Funktionen auf allen Ebenen erstellen, bearbeiten, löschen

- Bild-Management, Datenbank-Operationen, Website-Operationen, Sicherheits- und Audit-Funktionen

- kurz: Alles, was das Herz begehrt, kann über Schnittstellen gemacht werden.

Gleichzeitig lagen die Prämissen auf:

- Hohe Flexibilität, Sicherheit, Wartbarkeit des Codes.

- Größtmögliche Unabhängigkeit von externen Frameworks oder Systemen bei gleichzeitig maximaler Kompatibilität mit anderen Schnittstellen-Systemen.

- Enorme Performance, energiesparendes, barrierefreies Design.

- KI-Prozesse bereits in jeder Grund-Komponente integriert.

Warteschlangen sind Dein Freund bei allen Textprojekten. Nicht nur bei "großen" Textprojekten, sondern bei allen. Stell Dir vor, Du willst 10 oder 1000 Produktbeschreibungen überarbeiten. Ohne Warteschlange würdest Du 10 oder 1000 mal manuell ІдіотGPT mit einem Briefing füttern, "Text erstellen" klicken und warten. Mit Warteschlange packst Du alle Aufträge rein, das System arbeitet sie nacheinander ab, und Du bekommst am Ende alle fertigen Strukturen, die ins Kritiker-System laufen.

Selbst bei "nur" 10 Inhalten braucht es Warteschlangen. Aus einem einfachen Grund: Wenn Du das Thema "Texte" aus einer zyklischen Perspektive denkst, braucht es für die unterschiedlich rhytmisierten Ereignisse der Welt eine Menge dynamische Inhalte. Allein dafür braucht es ein System, das gesteuert und autark Deine Ideen und Aufträge abarbeitet.

Ein praktisches Beispiel: Du führst neue Produkte ein und brauchst für jedes eine Beschreibung, eine Meta-Description und für 12 Monate Social-Media-Beiträge. Das System nimmt die Produktdaten, erstellt alle Texttypen, legt sie in die entsprechenden System-Felder und stellt sie zur Überarbeitung bzw. die Kritiker-Instanz bereit. Von dort aus läuft der Prozess weiter.

3.2 Inhalts-Datenfluss-Verwaltung

Hier geht es um die Formate. KI erstellt Text, aber in welchem Format? Als einfacher Text? Als HTML? Als JSON? Als Markdown? Je nach Verwendungszweck brauchst Du verschiedene Ausgaben, und das System muss wissen, was wann gebraucht wird.

Die wichtigsten Formate:

- HTML für die direkte Website-Einbindung mit allen Formatierungen

- Markdown für Inhaltsverwaltungssysteme, die diese Auszeichnungssprache verstehen

- Einfacher Text für weitere Bearbeitung oder für Systeme, die keine Formatierungen akzeptieren

- JSON für strukturierte Daten, die von anderen Systemen weiterverarbeitet werden

Praxis-Tipp: Versionierung wird oft übersehen, ist aber kritisch. Wenn Du einen Text überarbeiten lässt, was passiert mit der alten Version? Ist sie weg? Kannst Du sie wiederherstellen? Was, wenn die neue Version schlechter ist als die alte? Ein gutes System behält alle Versionen und lässt Dich jederzeit zurück wechseln.

Richtig gut wird es, wenn Du zu jeder Variante den Prompt mit speicherst und ein gewichtetes Bewertungs-System drüber laufen lässt: Dann kannst Du KI-Systeme auf der Basis normalisierter Werte zeigen, welche Formulierungen in welchem Kontext funktional bzw. dysfunktional sind.

Noch ein Praxis-Tipp: Nachverfolgbarkeit ist besonders in größeren Unternehmen wichtig. Wer hat den Text wann erstellen lassen? Welches Briefing wurde verwendet? Wer hat ihn freigegeben? Diese Meta-Informationen können später Gold wert sein, wenn Fragen auftauchen oder Prozesse optimiert werden sollen.

Bevor die Frage kommt: Ja, ein guter Text kann im Laufe seines Lebens ein Vielfaches an Meta-Informationen von seinem eigenen "Körpergewicht" erzeugen. Und das ist sehr wertvoll!

3.3 Website-Integration ohne Kopfschmerzen

Die häufigste Frage: "Wie bekomme ich die KI-Texte in meine bestehende Website, ohne dass alles kaputt geht oder es irre aufwendig wird?" Die Antwort: Schrittweise und mit Sicherheitsnetz.

Aus meiner Sicht ist für das Thema "organisches SEO", aber auch für die spätere Erfassung durch andere Systeme eine Anbindung an entsprechende Suchmaschinen-Werkzeuge ein Muss (Rankings-Systeme, Performance-Systeme etc.). Die KI kann Dir fantastische Texte schreiben, aber wenn sie nicht für andere (Such-)Systeme optimiert sind, kann Potential verloren gehen. Deine SEO-Tools müssen der KI sagen können: "Verwende diesen Suchbegriff-Cluster, im Detail mit dieser Termgewichtung", "Verwende diese Werte für die relative Lesbarkeit", "Verwende diese 10 Sätze für die Meta-Description".

Eine gute Analytics-Integration hilft Dir zu verstehen, welche KI-Texte funktionieren und welche nicht. Welche Seiten haben durch neue Texte bessere Verweildauern, Scrolltiefen, Mikro-Interationen? Wie haben sich Konversionen verändernt? Diese Daten fließen zurück in das Nachbriefing und machen das System kontinuierlich besser.

Inhaltsverwaltung und Veröffentlichungs-Arbeitsabläufe sind der Schlüssel für den Alltag. Nicht jeder Text soll sofort live gehen (solche Texte wie diesen hier schiebe ich gerne ein paar Monate vor mir her). Manche brauchen Freigaben, manche sollen zu bestimmten Zeiten veröffentlicht werden, manche sind nur für bestimmte Nutzergruppen gedacht. Das System muss diese Regeln kennen, d.h. Du gestaltest und integrierst sie.

Ein Wort zur Sicherheit: KI-generierte Texte können theoretisch alles enthalten. Ein gutes System hat neben dem obligatorischen Kritiker-System Sicherheitsfilter, die problematische Inhalte automatisch erkennen und zur manuellen Prüfung weiterleiten. Besser einmal zu viel geprüft als einmal zu wenig.

4. KI-Text-Assistent: Das Herzstück der Inhaltserstellung

Hier passiert die eigentliche Magie. Der KI-Text-Assistent nimmt Dein Briefing und verwandelt es in Text. Klingt einfach, ist aber komplex. Die KI muss Deine Anforderungen verstehen, den Kontext erfassen, die richtige Tonalität treffen und dabei auch noch grammatisch korrekt und inhaltlich sinnvoll schreiben.

Da gibt es ein paar Missverständnisse: Der KI-Assistent ist kein Textgenerator, der nach dem Zufallsprinzip Wörter aneinanderreiht. Er ist ein Sprachmodell, das aus Milliarden von Texten gelernt hat, wie Menschen kommunizieren. Er "versteht" nicht im menschlichen Sinne, aber er erkennt Muster, Zusammenhänge und Strukturen.

Meine Erfahrung: Die Qualität hängt massiv davon ab, wie gut Du den Assistenten fütterst und mit Deinen eigenen, einzigartigen Inhalten trainierst. Gute Ergebnisse basieren auf einzigartigen und technisch sauber aufbereiteten Daten, präzisen Briefings und iterativen Prozessen.

4.1 Text-Eingabe-Verarbeitung und Kontext verstehen

Der erste Schritt ist entscheidend: Die KI muss Dein Briefing richtig interpretieren. Das klingt trivial, ist aber knifflig. Menschen kommunizieren oft indirekt, verwenden Andeutungen, setzen Dinge als selbstverständlich voraus. KI braucht Klartext, d.h. Beschreibungen, die möglichst nahe an eine kollektiv akzeptierte Realität kommt.

Markenrichtlinien, Deine internen Wissens-Sammlungen und Styleguides werden hier richtig starken Hebeln: Wenn die KI weiß, dass Dein Unternehmen immer "Sie" (oder Du) sagt (das ist z. B. offensichtlich eine Besonderheit bei mir, weil ich das "Du" grundsätzlich groß schreibe), nie Ausrufezeichen verwendet und komplizierte Fachbegriffe erklärt, kann sie das automatisch umsetzen. Ohne diese Vorgaben musst Du es in jedem Briefing neu erklären. Das ist also Bestandteil von Trainingsdaten (oder, wer gleich die große Nummer drehen möchte, integraler Bestandteil des Modells) und/ oder dem strukturellen/ grundsätzlichen Briefing.

Bedargsgruppen-Bewusstsein (weniger: Zielgruppen) ist ein weiterer kritischer Punkt. "Schreibe für Unternehmer" ist zu vage. "Schreibe für %Funktion% in Handwerksbetrieben mit 10 bis 50 Mitarbeitern, die %gravierendes-bedarfsauslösendes-Ereignis%, aber Angst vor %primäre-Angst% haben"; damit können moderne KI-Systeme recht gut arbeiten.

Praxis-Tipp:Tonalitäts-Verständnis entwickelt sich über Zeit! Es genügt nicht zu sagen: "Schreibe im Stil von Karl Kratz". In den ersten Wochen wirst Du oft nachkorrigieren müssen: "Weniger förmlich", "Mehr Vertrauen schaffen", "Direkter zum Punkt kommen", "karliger schreiben". Aber die KI lernt aus diesen Korrekturen und wird treffsicherer, wenn Du sie entsprechend aufbereitest und z. B. im Vector-Store hinterlegst.

4.2 Inhaltserzeugung mit System

Hochglanzprospekt: "Die KI bekommt Deine Stichworte und Vorgaben und erstellt daraus vollständige Website-Texte".

Realität: Das funktioniert, weil sie gelernte Muster anwendet. Wie beginnt eine gute Produktbeschreibung? Wie ist ein überzeugender Landingpage-Text aufgebaut? Welche Elemente braucht ein Handlungsaufruf?

Verschiedene Text-Formate erfordern verschiedene Herangehensweisen:

- Überschriften folgen anderen Regeln als Fließtexte.

- Aufzählungen haben andere Anforderungen als Handlungsaufrufe.

- Produktbeschreibungen brauchen andere Elemente als Blog-Artikel.

- Interaktive Funktionen brauchen andere Abstraktions-Ebenen als Texte.

Suchmaschinenoptimierung und Suchbegriff-Integration passiert idealerweise unauffällig. Die KI baut die relevanten Begriffe natürlich in den Text ein, ohne dass es gekünstelt wirkt. Und dennoch: In wettbewerbsstarken Branchen wirst Du um den Einsatz von SEO-Tools nicht herumkommen. Allein aus dieser Perspektive lohnt es sich, ein schnittstellenbasiertes Web-System zu betreiben.

Ein Beispiel aus der Praxis: Du willst eine Produktbeschreibung für "nachhaltige Büromöbel". Die KI erstellt nicht nur den Haupttext, sondern auch Überschrift, Untertitel, Aufzählungspunkte mit den wichtigsten Vorteilen, eine Meta-Description für Suchmaschinen und einen Handlungsaufruf. Alles in einem Durchgang, alles aufeinander abgestimmt.

Und dann fängt es eigentlich erst an: Die KI erstellt auf Basis des Prozesses und definierter Vorlagen, interaktive Beratungs-Systeme, dynamische FAQ, Rechner, Planungswerkzeuge und Simulatoren zu entwickeln. Diese Wiederum gelangen durch den Prozess zur Kritiker-Instanz und werden validiert bzw. weiter entwickelt.

4.3 Lernmechanismen, die funktionieren und Freude machen

Hier wird es spannend. KI-Systeme können mit jedem Text, mit jeder Feedback-Information, mit jeder Wiederholung lernen. ABER: Wir müssen es den Systemen "beibringen". Welche Formulierungen kommen gut an? Welche Strukturen führen zu besseren Ergebnissen? Welche Tonalität passt zu welcher Bedarfsgruppe? Diese Erkenntnisse fließen nur dann in zukünftige Texte ein, wenn wir sie systematisch in die Nachbriefings integrieren.

Anpassung an Marken-Sprache passiert z. B. schrittweise über laaaange Zeiträume. Die ersten Texte klingen noch generisch und wie ChatGPT1.0. Nach ein paar Wochen und mehreren Nachbriefings entwickelt die KI "ein Gefühl" für Deinen Stil. (Nein, das ist Bullshit. Sie entwickelt kein Gefühl, sondern wir erhöhen die Wahrscheinlichkeit, dass bestimmte Muster erzeugt werden). Nach einigen Monaten schreiben so trainierte KI-Systeme Texte, die sich (fast) anhören, als kämen sie aus Deiner Feder.

Damit dieser Mechanismus funktional gelingt, ist weniger eine Frage der Menge an Trainingsdaten, sondern eher eine Frage der Anzahl der Iterationen und Feedback-Schleifen.

Leistungsdaten sind dann der Turbo für das Lernen. Wenn die KI weiß, welche Texte zu mehr Verkäufen, längeren Verweildauern oder besseren Bewertungen führen, kann sie diese Erfolgsrezepte auf neue Texte übertragen. Aus zufälligen Treffern werden systematische Erfolge.

Praxis-Tipp:Normalisiere alle Leistungsdaten! Wann immer Du einem KI-System etwas vermitteln möchtest, orientiere Dich an einer normalisierten Skala, z. B. von 0 bis 1: Sonst werden später Äpfel mit Socken verglichen.

Mit Blick auf das Thema Personalisierung geht's dann noch einen Schritt weiter. Verschiedene Bedarfsgruppen (aufgrund z. B. unterschiedlicher Ereignisse) brauchen verschiedene Ansprachen. Die KI kann lernen, dieselbe Information für verschiedene Personas unterschiedlich zu formulieren.

Was dabei passiert: Die Formulierungen, Tonalität und Struktur werden mit mehr Trainingsdaten, besseren semantischen/ontologischen Modellen und systematischen Nachbriefings kontinuierlich präziser. Das System wird nicht "kreativ", sondern folgt den erlernten Mustern immer genauer. Je mehr gute Beispiele und klare Korrekturen, desto treffsicherer die Ergebnisse.

5. Inhalts-Ausgabe und Text-Formatierung

Hier entscheidet sich, ob Deine KI-Texte wirklich nutzbar sind oder ob Du stundenlang nachformatieren musst. Das Problem kenne ich aus vielen Projekten: Die KI schreibt einen guten Text, aber er kommt in einem zufälligen Format raus, das nirgendwo passt. Dann sitzt Du da und kopierst manuell Absätze, fügst HTML-Tags ein und baust Überschriften um.

Die Lösung: Das System muss von Anfang an wissen, wofür der Text gedacht ist: Website-Integration, Newsletter, Social Media, Produktkatalog, Werbemittel; jeder Verwendungszweck braucht andere Formate und Strukturen. Ein gutes System liefert den Text gleich in der Form, die Du tatsächlich brauchst.

Praxis-Tipp: Da du ohnehin grundsätzlich ein Post-Processing der KI-Ausgabe brauchst, lohnt es sich, an dieser Stelle über Validierung, Konformitätsprüfung und Konvertierung nachzudenken. Manchmal entsteht auf diese Weise schon eine Feedback-Schleife, die dafür sorgt, dass bei der Kritiker-Instanz nur Inhalte ankommen, die bereits das korrekte Format haben.

Was oft übersehen wird: Formatierung ist nicht nur Kosmetik, sondern beeinflusst massiv die Wirkung des Textes. Ein Text, der als Fließtext gut funktioniert, kann als HTML-Seite langweilig wirken. Umgekehrt können strukturierte Listen in einem Newsletter zu technisch aussehen.

5.1 Mehrformat-Ausgabe

Wenn ich an einen "Text" denke, dann denke ich grundsätzlich an unterschiedliche Formate UND Meta-Informationen. Zum Beispiel:

Als HTML für Website-Integration mit allen nötigen Formatierungen ist Standard. Aber Vorsicht: Nicht jedes CMS akzeptiert jeden HTML-Code. Manche Systeme filtern bestimmte Tags raus, andere haben eigene Formatierungsregeln. Die KI muss wissen, welches System sie "füttert" bzw. welche Tags erlaubt sind und welche nicht.

Dann als Markdown für Inhaltsverwaltungssysteme, die diese Auszeichnungssprache verstehen. Markdown ist praktisch, weil es menschenlesbar bleibt, aber trotzdem Formatierungen enthält. Das ist perfekt für Systeme wie GitHub, aber auch viele moderne CMS können damit umgehen. Meine persönliche Eigenart ist die Anreicherung von Markdown mit JSON, da ich meine Systeme im Lauf der Zeit dafür optimiert habe.

Auch als einfacher Text für weitere Bearbeitung oder für Systeme, die keine Formatierungen akzeptieren. Das klingt banal, ist aber wichtig. Manchmal willst Du den Text erst mal nur lesen und bewerten, bevor Du Dich um Formatierung kümmerst. Und manche Systeme KÖNNEN nur Text; gerade bei Lösungen im Bereich der Barrierefreiheit ist blanker Text wichtig.

Dann JSON für strukturierte Daten, die von anderen Systemen weiterverarbeitet werden. Hier wird der Text in seine Bestandteile zerlegt: Überschrift, Untertitel, Haupttext, Handlungsaufruf, Metadaten. Jedes System kann sich dann die Teile rauspicken, die es braucht.

Und wer mag, kann hier noch weiterdenken: Ein Text ist bei mir auch gleichzeitig immer parametrisiert/ dynamisiert. Das bedeutet, dass ich mit Variablen und dynamischen Text-Passagen arbeite, um die Resonanz- bzw. Anschlussfähigkeit zu erhöhen.

Hinter den Kulissen: In vielen Fällen kopple ich "Verhalten" mit der "didaktischen" Anschlussfähigkeit von Inhalten. Du kannst z. B. die Interaktion mit bestimmten Frage/Antwort-Segmenten messen. Darüber erhältst Du einen Einblick in das kontextuelle Verhalten. Und das wiederum entscheidet, welche dynamische Variante eines Textes jemand angezeigt bekommt (sehr einfach bis komplex).

5.2 Baustein-basierte Text-Ausgaben

Modulare Inhaltsgliederung ist der Schlüssel schlechthin für flexible Texte. (Ich habe dazu vor langer Zeit ein Komponenten-Modell entwickelt; Notiz an mich: #todo Komponenten-Modell bereitstellen) Statt eines langen Textblocks bekommst Du strukturierte Komponenten: Überschrift, Einleitung, Hauptteil, interaktive Dialog-Komponente, Multimediale Komponenten, Vorteile-Liste, Handlungsaufforderung, Konversion-Ele,ent. Jeder Baustein kann einzeln verwendet, ausgetauscht oder angepasst werden - vielleicht dämmert es jetzt, warum man um ein Warteschlangen-basiertes System nicht herumkommt ... ;-)

Wiederverwendbare Text-Bausteine sparen enorm Zeit. Wenn Du einmal eine gute Einleitung für Produktbeschreibungen hast, kann sie als Vorlage für ähnliche Produkte dienen. Die KI variiert dann nur die spezifischen Details, behält aber die bewährte Struktur bei.

Vorlagensysteme für verschiedene Seitentypen machen das Leben einfacher:

- Eine Produktseite braucht andere Elemente als eine Über-uns-Seite

- Eine Landingpage hat andere Anforderungen als ein Blogartikel

- Ein Newsletter folgt anderen Regeln als Social-Media-Posts

- Eine interaktive Funktion braucht eine komplett andere Abstraktion als eine Textseite

Ein praktisches Beispiel: Du erstellst Texte für einen Online-Shop. Das System liefert Dir für jedes Produkt automatisch: Produktname (H1), Kurzbeschreibung, ausführliche Beschreibung mit Vorteilen, technische Details als Liste, Kundennutzen-Abschnitt, Handlungsaufforderung und Meta-Description. Alles fertig formatiert für Dein Shop-System.

Das ist schonmal praktisch und bequem. Zusätzlich integrieren sich die "Text"-Packages mit ihren Meta-Informatonen automatisch in das jeweilige Kaufberatungs- oder Vergleichssystem. Sprich: Der Text und die Meta-Informationen des Textes bestimmen die Funktion in anderen Systemen.

5.3 Zielgruppen-angepasste Text-Formatierung

Verschiedene Menschen lesen unterschiedlich. Manche Menschen überfliegen meist nur die wichtigsten Punkte. Andere wollen Details. Manche oder viele brauchen emotionale Ansprache. Das System muss diese Unterschiede in der Formatierung und Ausgestaltung berücksichtigen.

Geräte-optimierte Inhaltsdarstellung wird immer wichtiger. Ein Text, der auf dem Desktop gut lesbar ist, kann auf dem Smartphone furchtbar aussehen. Lange Absätze, komplizierte Tabellen, verschachtelte Listen funktionieren mobil nicht. Die KI sollte das bei der Formatierung berücksichtigen.

Wen das Thema interessiert: Ich hatte vor langer Zeit etliche Module zum Thema "responsive Content" in den Seminaren vorgestellt. Wenn genug Interesse vorhanden ist, greife ich das Thema gerne nochmal auf.

A/B-Test-Varianten für verschiedene Zielgruppen sind ein mächtiges Werkzeug. Dieselbe Information, aber für unterschiedliche Intentionen unterschiedlich formatiert und strukturiert. Variante A mit vielen Zwischenüberschriften für Scanner, Variante B mit Fließtext für gründliche Leser. Das System erstellt beide auf der Basis Deiner Trainingsdaten und Deines Briefings.

Was ich in der Praxis oft sehe: Unternehmen erstellen einen Text und setzen ihn überall ein. Website, Newsletter, Social Media, Broschüre. Das funktioniert auf seine Weise, bleibt in seinem Möglichkeiten dann dennoch zurück. Jeder Kanal braucht eine angepasste Formatierung, auch wenn der Inhalt derselbe bleibt. Mit einer guten prozessualen KI-Integration können diese Anpassungen automatisch vorgenommen werden.

6. Text-Kritiker-Funktion: Inhalts-Qualitätssicherung

Hier trennt sich die Spreu vom Weizen. Jeder kann KI-Texte erstellen lassen. Aber nur wer eine systematische Qualitätskontrolle einbaut, bekommt wirklich gute Ergebnisse. Das Problem: Die meisten schauen sich den Text kurz an, denken "passt schon" und veröffentlichen. Dann wundern sie sich, warum die Texte nicht die gewünschte Wirkung haben.

Meine Erfahrung: Ohne Kritiker-Funktion plus Feedback-Schleife plus Anreicherung der Trainingsdaten bleibt KI-Texterstellung Glückssache. Mal gut, mal schlecht, aber nie systematisch funktional, mit einer Ausrichtung auf Deine Unternehmensziele. Die Kombination aus (Qualitäts-)Kontrolle + Feedback-Loop + kybernetische Korrektur werden sogar ganz "kleine" KI-Systeme zu mächtigen Werkzeugen: Auf diese Weise habe ich mit einer lokalen Ollama-Instanz, dem LLM gemma3 und einer ChromaDB voll mit meinen E-Books "karl-ähnliche" Texte erzeugt!

Die Kritiker-Funktion kann technisch oder menschlich sein. Beide Ansätze haben Vor- und Nachteile. Entscheidend ist: Sie muss systematisch und konsequent angewendet werden. Sporadische Kontrollen nach Bauchgefühl bringen nichts.

6.1 Automatisierte Text-Qualitätsprüfung

Grammatik- und Rechtschreibprüfung ist das Mindeste, was passieren sollte. Aber moderne Systeme können ja so viel mehr: Sie erkennen stilistische Schwächen, prüfen Satzlängen, analysieren Lesbarkeit und identifizieren Wiederholungen.

Tonalitäts- und Styleguide-Einhaltung ist technisch anspruchsvoller, aber machbar. Das System lernt aus Deinen normalisiert bewerteten Referenztexten, Deinen semantischen und ontologischen Modellen, wie Deine Marke klingt. Zu förmlich? Zu salopp? Passt nicht zur Zielgruppe? Mit einem guten, iterativen Prozess analysierst Du systemisch und wirkst Du kybernetisch Stück für Stück in die Richtung, "wie es sein soll".

Suchmaschinenrelevante Faktoren und Prüfungen:

- Sind die wichtigen Begriffe enthalten: Unmissverständliches Termgewichtungssignal, beweisführende Begriffe, Signal für Unterschiedlichkeit, Rausch-Signal-Verhältnis?

- Ist das Dokument für eine funktionale relative Lesbarkeit zu Marktbegleiter-Dokumenten optimiert?

- Werden strukturierte Daten (z.B. JSON-LD) eingesetzt?

Was eine programmatische, automatische oder KI-basierte Prüfung nicht kann: Den realen Kontext verstehen. Ob ein Text zur aktuellen Marktsituation passt, ob er die richtigen Emotionen anspricht, ob er überzeugend argumentiert. Dafür braucht es menschliche Bewertung.

6.2 Menschliche Inhalts-Bewertung

Wann braucht es menschliche Prüfung? Bei strategisch wichtigen Texten immer. Bei Standardtexten wie Produktbeschreibungen kann oft die Automatik reichen. Bei rechtlich relevanten Inhalten ist menschliche Kontrolle Pflicht. Bei kreativen Texten sowieso.

Die Balance zwischen Automatisierung und manueller Qualitätskontrolle ist ja entscheidend für die Effizienz: Alles manuell prüfen kann zu langsam und zu teuer sein. Alles automatisch prüfen führt zu Qualitätsproblemen (und wahrscheinlich der einen oder anderen Abmahnung). Aus der Praxis empfehle ich meistens: Automatik für die Grundlagen, Menschen für die strategischen und kreativen Aspekte.

Eskalations-Mechanismen für kritische Inhaltsprobleme müssen klar definiert sein:

- Was passiert, wenn die automatische Prüfung rote Flaggen zeigt?

- Wer wird informiert?

- Wer entscheidet über Veröffentlichung oder Überarbeitung?

- Wie schnell muss reagiert werden?

Ein praktisches Beispiel: Produktbeschreibungen laufen durch die Automatik. Grammatik, Rechtschreibung, Suchmaschinenoptimierung, Tonalität werden automatisch geprüft. Nur wenn Probleme erkannt werden oder wenn es sich um neue Produktkategorien handelt, kommt der Text zur menschlichen Prüfung. Pressemitteilungen dagegen werden immer manuell kontrolliert.

(Ich bin so frei: Ja, das gibt es auch genau so anders herum ... ;-) ).

6.3 Rückmeldungs-Integration

Von Kritik zu konkreten Verbesserungsvorschlägen ist der entscheidende Schritt. "Der Text ist nicht gut" würde ja im echten Leben niemandem helfen. "Zu wenig emotionale Ansprache in Absatz 2, Handlungsaufruf zu schwach, Zielgruppe nicht klar angesprochen" ist auch fad.

KI Systeme lernen gut durch eine Mischung aus abstrahierten Beschreibungen in Kombination mit echten Beispielen und Bewertungen für die Einordnung der Bedeutung.

- Zeig ganz konkrete Beispiele: "Statt 'Unsere Software optimiert Ihre Prozesse' schreibe 'Unsere Kunden sparen nachweislich 3 Stunden täglich mit automatisierten Reports für XY'. Also statt eines abstrakten Versprechens (ich nenne das "attributoriente Angebotskommunikation") zeigst Du das Nutzenversprechen, das Vorteilsversprechen und das Wertversprechen. (Notiz an mich: #ToDo Bedarfsgruppenmodell integrieren)

- Problem + Lösung + Begründung: "Der Einstieg ist zu technisch. Beginne mit einer Frage, die das Problem des Lesers anspricht: 'Kennen Sie das: Es ist 19 Uhr und Sie sitzen immer noch an Excel-Reports?' Das holt Menschen emotional ab."

- Vorher-Nachher demonstrieren: "Original: 'Wir bieten innovative Lösungen' wird zu Besser: 'Ihre Kunden warten durchschnittlich 8 Minuten. Mit uns nur noch 2.' Warum: Spezifisch, messbar, relevant."

- Strukturierte Verbesserungsmatrix: Was funktioniert (der technische Teil ist korrekt) + Was fehlt (emotionaler Hook) + Wie es besser geht (Starte mit Kundenzitat) + Konkretes Beispiel ("Als mein Lager überfüllt war...")

- Die "Zeig-es-mir"-Methode: "Mache aus dem Beamtendeutsch eine Geschichte. Verwandle 'Effizienzsteigerung durch Digitalisierung' in 'Maria aus Hamburg hat ihre Lieferzeiten halbiert. So hat sie es gemacht:'"

- Kontext-Shift-Feedback: "Stelle dir vor, du erklärst das deinem skeptischen Onkel beim Familienessen. Wie würdest du dann formulieren? Genau diese Sprache brauchst du hier."

- Mustererkennung fördern: Gib 2-3 gelungene Beispiele mit: "Siehst du das Muster? Konkret statt abstrakt, Nutzen statt Feature, Story statt Floskel."

Lernende Inhaltsbewertungssysteme werden mit jedem Kritik-Feedback-Loop besser. Dafür brauchst Du nur die Augen offen halten: Welche Probleme tauchen häufig auf? Welche Texttypen brauchen besondere Aufmerksamkeit? Welche Kritikpunkte führen zu den besten Verbesserungen? Wenn Du das als Feedback auf eine prozessuale Weise zurückmeldest, kann das System diese Muster lernen und in zukünftige Formulierungen einbauen.

Für alle, die lieber beim "Altbewährten" bleiben: Kontinuierliche Anpassung der Text-Qualitätskriterien ist auch deshalb notwendig, weil sich "externe" Anforderungen immer und immer wieder ändern. Was vor einem Jahr ein guter Text war, kann heute veraltet sein. Es gibt dann neue Ziel- und Bedarfsgruppen, veränderte Marktbedingungen, andere Wettbewerber ... all das beeinflusst, was "gute Qualität" überhaupt bedeutet.

Der wichtigste Punkt: Jede Kritik führt automatisch zu einem Re-Briefing. Das ist kein optionaler Schritt, sondern fester Bestandteil des Prozesses. Übrigens: "Text war ok" ist genauso ein Re-briefing wie "Komplett überarbeiten". Das System lernt aus beidem.

Was ich dabei gelernt habe und auch immer besser verstehe: Die besten Kritiker-Systeme sind hybrid. Automatik für die Routine, Menschen für die Strategie, und beide lernen voneinander. Die Automatik wird durch menschliche Bewertungen trainiert, wir Menschen werden durch automatische Vorprüfung entlastet.

Aber: Ich nutze KI-Systeme auf eine prozessuale Weise *exzessiv*. Und ich beobachte mich selbst dabei sehr aufmerksam. Das wird vielleicht einen anderen Artikel brauchen, weil das zu umfangreich wird: Aber die intensive Arbeit mit KI-Systemen geht an unseren menschlichen Systemen nicht ohne Spur vorbei. Aber dazu schreibe ich wann andermal.

7. Text-Überarbeitungs-Arbeitsabläufe

Hier wird entschieden, ob Dein KI-System wirklich effizient wird oder ob Du in Überarbeitungsschleifen versinkst. Das klassische Problem: Der Text kommt zurück mit Kritik, jemand muss ihn überarbeiten, das dauert, kostet Geld, und am Ende ist er vielleicht immer noch nicht perfekt.

Was ich in vielen Unternehmen beobachte: Da wird gedacht, KI macht alles automatisch, aber dann sitzt trotzdem jemand stundenlang da und verbessert Texte manuell. Das ist das Gegenteil von dem, was KI leisten sollte. Richtig gemacht, übernimmt das System den Großteil der Überarbeitung selbst.

Die Kunst liegt darin, den richtigen Überarbeitungsweg für jeden Texttyp zu finden. Standardtexte können oft vollautomatisch optimiert werden. Strategische Inhalte brauchen menschliche Kontrolle. Die meisten Texte liegen irgendwo dazwischen und profitieren von teilautomatisierten Prozessen.

7.1 Manuelle vs. teilautomatisierte Text-Überarbeitung

Bei diesem Thema braucht es ein bisschen Kosten-Nutzen-Analyse: Wie viel Zeit kostet manuelle Überarbeitung? Wie gut wird das Ergebnis? Wie oft muss nachgebessert werden? Dagegen: Wie gut funktioniert die automatische Überarbeitung? Wo sind ihre Grenzen? Was spart sie wirklich ein?

Fähigkeitsanforderungen für manuelle Inhaltsoptimierung sind höher, als viele denken. Es reicht ja nicht, Rechtschreibfehler zu korrigieren. Gute Text-Überarbeitung braucht Verständnis für Bedarfsgruppen, Markenstrategie, Suchmaschinenoptimierung, Psychologie und Verkaufstechniken. (Solche Leute sind teuer und selten).

Der Automatisierungsgrad bei verschiedenen Text-Typen kann z. B. so geplant werden:

- Produktbeschreibungen: 80% automatisch

- Blog-Artikel: 50% automatisch

- Pressemitteilungen: 20% automatisch

- Rechtliche Texte: 0% automatisch

Ein Beispiel aus der Praxis: Eine E-Commerce-Firma hat 5.000 Produktbeschreibungen. Manuelle Überarbeitung würde Monate dauern und ein Vermögen kosten. Teilautomatisiert geht es so: KI erkennt die häufigsten Kritikpunkte, schlägt Verbesserungen vor, ein Mitarbeiter prüft stichprobenartig und gibt das System frei.

Bei ein paar Kunden habe ich solche Aufgaben so gelöst:

- Mit dem Content-Score in karlsCORE wird eine Art "Gesamt-Inventar" der Website erstellt.

- Jede URL erhält einen Score, der sich aus unterschiedlich gewichteten Metriken zusammensetzt (z. B. Traffic, Konversionen, E-Commerce Value etc.)

- URLs mit einem Score von 0-0.3 erhalten komplett automatisiert erstellte Texte mit einem günstigen Sprachmodell. Wenn da noch was passiert, ist's gut, wenn nicht, dann ist's auch ok.

- URLs zwischen 0.3 und 0.6 werden mit einem hochwertigen Modell automatisiert erstellt und Absteigend nach Score von einem höherkomplexen Modell in der Kritikerfunktion bewertet. Was durch's Raster fällt, wird von einem Menschen angeschaut.

- Alle höherwertigen URLs werden mit einem maximal komplexen Modell mit Texten versorgt und von Menschen durch einen Bewertungsprozess geleitet (z. B. in Bezug auf die emotionale Ansprache, gefühlte Stimmung/ Atmosphäre, Eineindeutigkeit etc.)

Das war dann eine pragmatische Lösung, um mit begrenzten Ressourcen (Anm.: Ich bin im Schwabenland groß geworden, da tendiert man zur Sparsamkeit) in relativ kurzer Zeit Angebote mit entsprechend ansprechenden Texten zu versehen.

7.2 Vollautomatisierte Optimierung

Sich selbst verbessernde Text-Systeme sind der Heilige Gral. Das System erkennt Schwachstellen, optimiert automatisch und lernt aus den Ergebnissen. Klingt fantastisch, funktioniert aber nur unter bestimmten Bedingungen.

Oder ich gehe nochmal einen Schritt zurück: Es ist, als lässt man einen digitalen Welpen auf die Würstchenkammer im Serverraum los. Man muss halt doch immer dabei sein und schauen, ob er in die Ecke gemacht hat oder in einem Endlosloop teure Tokens verbraucht. :-D

A/B-Test-basierte automatische Anpassungen sind z. B. ein realistischer Ansatz. Das System erstellt verschiedene Text-Versionen, testet sie gegeneinander und verwendet automatisch die erfolgreichere. Das funktioniert gut bei Texten mit messbaren Zielen: mehr Klicks, mehr Verkäufe, längere Verweildauer. Man kann über die Tage und Wochen zugucken und überall rechtzeitig intervenieren.

Aber: Die Grenzen der vollautomatischen Text-Optimierung sind wichtig zu verstehen:

- Das System kann Muster erkennen und nachmachen, aber es kann nicht strategisch denken. Und es tendiert immer zu irgendeiner Richtung, wie ein Auto mit einer leichten Delle im Lenksystem.

- Es weiß nicht, ob eine kurzfristig erfolgreiche Formulierung langfristig der Marke schadet (das wissen wir als Menschen vielleicht auch nicht, aber wir haben wenigstens eine Intuition UND wir tragen die Verantwortung für unsere Formulierungen).

- Es kann keine Marktveränderungen antizipieren oder kreative Durchbrüche erzielen, zumindest noch nicht.

Wo vollautomatische Optimierung gut funktioniert: Bei Standardtexten mit klaren Erfolgskennzahlen und ganz klaren Regeln! Dann z. B. bei Newsletter-Betreffzeilen, Produktbeschreibungen, Werbeanzeigen für niedrigkomplexe Angebote. Wo sie nicht funktioniert: Bei strategischen Inhalten, kreativen Texten, komplexen Argumentationen, interaktiven Funktionen.

Oder besser formuliert: Da habe _ich_ noch nichts sinnvolles hinbekommen. :-D

7.3 Arbeitsablauf-Steuerung

Die Entscheidungslogik für Text-Überarbeitungswege muss klar definiert sein, sonst "driftet das ganze System" innerhalb kürzester Zeit. Wann geht ein Text zur automatischen Überarbeitung? Wann zur teilautomatisierten? Wann zur rein manuellen? Diese Regeln müssen eindeutig sein, sonst entsteht Chaos.

Prioritätsverwaltung bei Inhaltsprojekten wird oft unterschätzt. Nicht jeder Text ist gleich wichtig:

- Die Homepage-Überarbeitung hat Vorrang vor der 47. Produktbeschreibung

- Pressemitteilungen sind wichtiger als interne Newsletter

- Rechtliche Texte haben Priorität vor Blog-Artikeln

- Oder wer es professioneller mag: Die Wichtigkeit eines Inhalts erschließt sich aus dem Score, der auf gewichteten und bewerteten Faktoren beruht.

Deadline-Management und Inhalts-Freigabe-Prozesse müssen ineinandergreifen (falls so etwas vonnöten ist). Was passiert, wenn ein wichtiger Text bis zur Deadline nicht fertig wird? Wer kann Freigaben erteilen? Wer darf Texte auch ohne finale Freigabe veröffentlichen? Diese Prozesse müssen vor der Krise definiert werden, nicht währenddessen. Allerdings habe ich derartiges bisher nur einmal im Konzernumfeld erlebt. Die allermeiste Zeit wurde der zeitliche Druck eher nur von intern erzeugt.

Ein praktisches System sieht z. B. so aus: Die automatische Überarbeitung läuft sofort. Die teilautomatisierte Überarbeitung startet, wenn ein Mensch für die Korrektur verfügbar ist. Die manuelle Überarbeitung wird nach Priorität und Deadline eingeplant. Und die Eskalation erfolgt automatisch, wenn Deadlines in Gefahr sind ...

Was dabei oft schief geht: Unternehmen definieren komplexe Workflows, aber vergessen die Ausnahmen. Was passiert bei Eilaufträgen? Bei kranken Mitarbeitern? Bei technischen Problemen? Bei ungeplanten Eingabeformaten? Ein robustes System hat für solche Fälle Fallback-Lösungen ... aber: Fallbacklösungen entstehen in der Regel erst unter Druck durch Incidents. ;-)

Ein Schmunzler aus der Praxis: Ein Geschäftsführer war es wichtig, an jedem Website-Text als "letzte" Instanz mitzuwirken. Allerdings war er der absolute Flaschenhals im System: Es kam nie dazu, aber der gesamte Prozess wollte weiterlaufen (vielleicht erinnerst Du Dich noch an das Thema "Warteschlangen" von ganz am Anfang? Dafür braucht man so etwas.)

Die Lösung war folgende Vereinbarung: "Wir haben hier das KI-System, dass die Texte auf Basis der Trainingsdaten erstellt. Dann haben wir hier ein höherkomplexeres KI-System, das den Kritiker macht. Zum Schluss schaut Manuela nochmal kurz drauf und stellt Dir das für die Freigabe rein. Wenn Du nicht innerhalb von 2 Tagen intervenierst, wird es automatisch deployed.

Fazit: Funktioniert heute noch. Guter Prozess. :-)

8. Inhalts-Bereitstellung und Website-Veröffentlichung

Hier zeigt sich, ob Dein KI-Text-System wirklich praxistauglich ist. Du hast einen perfekten Text, aber wie kommt er auf die Website? Wer gibt ihn frei? Wann wird er veröffentlicht? Was passiert, wenn etwas schief geht? Ohne durchdachte Bereitstellung versandet selbst das beste Text-System im Chaos.

Und dabei habe ich eine Menge gesehen: Filezilla-FTP-Gemuscher, Wordpress-Klick-Orgien, Zapier-Deployment-Prozesse mit monatlichen dreistelligen Rechnungen für banalste Automatisierungen ...

Das typische Problem: Texte stapeln sich in irgendwelchen Ordnern, niemand weiß, welche Version aktuell ist, Freigaben dauern ewig, und wenn endlich veröffentlicht wird, ist der Anlass längst vorbei. KI kann Texte in Minuten erstellen, aber wenn die Veröffentlichung Wochen dauert, ist der Vorteil weg.

Meine Erfahrung: Die technische Integration ist meist einfacher als die organisatorischen Prozesse. APIs funktionieren, CMS-Anbindungen klappen, aber die Frage "Wer darf was wann veröffentlichen?" sorgt für endlose Diskussionen.

Also, ganz pragmatisch: Bitte einmal durchdefinieren, damit der Prozess ein Prozess bleibt und nicht zur Sackgasse wird.

8.1 Text-Freigabe-Prozesse

Inhalts-Qualitätsbereiche und Genehmigungsabläufe müssen -zumindest in etwas größeren Organisationen- klar definiert sein. Damit meine ich alle Organisationen mit mehr als 0 (Null) Personen: Ich habe schon Einzelkämpfer sich mit solchen Prozessen verzetteln sehen. Welche Texte brauchen Freigaben? Von wem? In welcher Reihenfolge? Wie lange darf das dauern? Was passiert bei Verzögerungen? Diese Regeln müssen schriftlich festgehalten und allen Beteiligten bekannt sein.

Warum schriftlich?

Weil Du das dann als Markdown in Deinem System hinterlegen kannst und ein anderes KI-System, welches z. B. an Deinem Management-System arbeitet, diese Informationen übernehmen kann.

Redaktionelle Workflows und Verantwortlichkeiten sind oft das ein bisschen Chaos. "Das macht schon jemand" funktioniert nicht. Jeder Texttyp braucht einen klaren Verantwortlichen:

- Produkttexte: Marketing

- Rechtstexte: Rechtsabteilung

- Pressemitteilungen: PR

- Blogartikel: Redaktion

- Aber auch: Wer veröffentlicht was wann wo und wie kommen Feedback-Informationen zurück ins System?

Rückgängigmachung-Strategien bei problematischen Texten sind überlebenswichtig. Was machst Du, wenn ein veröffentlichter Text falsche Informationen enthält? Wenn er rechtlich problematisch ist? Wenn er der Marke schadet? Allein dafür lohnt es sich, den Prozess so zu verfeinern, dass man Rollback-Möglichkeiten hat.

Ein praktisches Beispiel: Ein Online-Shop mit täglichen Produktneuheiten. Es lief eine automatische Texterstellung in der Nacht, es gab eine automatische Freigabe durch das System (Grammatik, Suchmaschinenoptimierung, Markenstil), morgens dann manuelle Stichproben-Kontrolle durchs Produktteam, automatische Veröffentlichung am Nachmittag. Das war ein Traum.

Aber: Ein wesentlicher Teil der Inhalte (und Preise) basierte auf Scraping-Daten von Marktbegleitern. Einem Konkurrenten ist das eines Tages aufgefallen und er begann (wohl auch, um die Nachweisfähigkeit zu konstruieren), seine eigenen Inhalte mit bestimmten Formulierungen zu versehen, die vom KI-System des Online-Shops munter übernommen wurden ...

Eine Abmahnung später gab es eine Funktion: "Alles Stop und Rollback". Eine Emergency-Funktion sozusagen. :-)8.2 Website-Inhalts-Verteilung

Mehrkanal-Inhalts-Auslieferung ist heute Standard. Ein Text für die Website, eine Kurzversion für Social Media, eine Variante für den Newsletter, eine für die App. Ein halbwegs ausgereiftes KI-System sollte diese Versionen automatisch erstellen können und das meiste an die richtigen Kanäle verteilen können (je nach Schnittstellen).

Social Media und Newsletter-Integration funktioniert oft über APIs. Der neue Produkttext wird dann z. B. automatisch als Facebook-Post formatiert und in den nächsten Newsletter eingeplant. Manuelle Kopierei sollte jetzt so langsam wirklich der Vergangenheit angehören. Falls Du Kolleg:innen dabei beobachtest: Schick ihnen diesen Artikel, bitte.

Eine Veröffentlichung mit Blick auf die digitale Findbarkeit in Suchmaschinen bedeutet ja mehr als nur "Suchbegriffe im Text":

- Wann wird veröffentlicht?

- Sind alle Meta-Daten enthalten?

- In welcher internen Verlinkungsstruktur (internen Pagerank in Kombination mit interner Anchor-Text-Struktur beachten)?

- Werden die Sitemaps bzw. Hotmaps aktualisiert?

Wenn wir schon einen Prozess haben, dann sollten wir da über kurz und lang alles sorgsam reinintegrieren, was wir überblicken, überwachen und steuern können.

Das hilft dann auch bei der Zeitplanung: Ein Text über Weihnachtsgeschenke, der am 27. Dezember veröffentlicht wird, ist wertlos. So ein System wird also wertvoller, wenn es saisonale Themen, Produkteinführungen und Kampagnen-Zeitpläne berücksichtigt.

8.3 Inhalts-Leistungs-Verfolgung

Die Rückmeldung von Website-Besuchern zu Texten ist ja oft nur indirekt messbar. Zum Beispiel durch eine längere Verweildauer (kann auch einfach nur eingeschlafen sein), niedrigere Absprungrate, mehr Interaktionen. Aber: Das System sollte diese Daten automatisch sammeln und für die Textbewertung nutzen können. Je mehr und höherdimensionale Metriken wir bekommen können, umso besser!

Was ganz pragmatisch umsetzbar ist:

- Welche Überschriften werden häufiger geklickt?

- Welche Produktbeschreibungen führen zu mehr Käufen (im A/B-Test)?

- Welche FAQ Frage-Antwort-Kombinationen werden öfter aufgeklickt?

Ein Standard-Prozess für den letzten Punkt sieht so aus: Frage-Antwort-Kombinationen mit hohen Interaktionen werden visuell priorisiert (sie stehen weiter oben). Frage-Antwort-Kombinationen OHNE Interaktionen verschwinden von der Website und es wird KI-basiert eine neue Frage-Antwort-Kombination ins System eingebracht. Dann wird weiter gemessen.

Kontinuierliche Text-Optimierung durch Nutzerdaten schließt quasi den Kreis. Die Leistungsdaten fließen zurück in die RE-Briefings, die KI lernt aus erfolgreichen Mustern, zukünftige Texte werden besser. Aus statischen Inhalten werden sich entwickelnde, optimierende Systeme.

Ein Beispiel aus der Praxis: Eine Nachrichtenseite verfolgt, welche Artikel-Überschriften höhere Klickraten haben. Diese Erkenntnisse fließen automatisch in die KI-Briefings für neue Artikel ein. Binnen weniger Wochen steigen die durchschnittlichen Klickraten um 30%, ohne dass jemand manuell optimiert hätte.

Aber: Mit solchen "einfachen", trivialen Feedback-Loops richtet man in der Regel langfristig in erster Linie Schaden an. Und das meine ich sehr ernst. Schau Dich auf der Welt um ...

Der kritische Erfolgsfaktor für einen funktionalen Prozess ist also der integrative Umgang mit diesen Bereichen: Texterstellung, Freigabe, Veröffentlichung und Leistungsmessung, die müssen nahtlos ineinandergreifen. Jeder Bruch in der Kette macht meist das ganze System ineffizient. Ich sag da immer: Lieber ein einfaches, aber vollständig integriertes System als ein Komplexes mit Lücken.

9. Inhalts-Datenbank und Wissens-Verwaltung

Hier liegt aus meiner Sicht der Schatz, den die meisten Unternehmen nicht heben. Über Jahre sammeln sich Texte, Dokumente, Styleguides, erfolgreiche Formulierungen, bewährte Strukturen. Ohne systematische Verwaltung verschwinden diese Goldstücke in irgendwelchen Ordnern und werden nie wieder gefunden.

Das Problem kenne ich aus so vielen Fällen: "Wir hatten schon mal einen richtig guten Text zu dem Thema, aber wir finden ihn nicht mehr." Oder: "Der neue Kollege soll Texte im Stil der Marke schreiben, aber niemand kann ihm sagen, wie der eigentlich klingt." Ohne Wissens-Verwaltung fängt jeder bei null an. Deshalb: Alles einkassieren, zentralisieren, konvertieren. :-)

Je mehr Referenzmaterial wir als Unterscheidungskriterium gegenüber dem Durchschnitt der Welt haben, desto besser werden unsere Ergebnisse. Eine gut gepflegte Inhalts-Datenbank ist wie eine Garantie für Unterschiedlichkeit bei der KI-basierten Text-Erstellung. Schlecht gepflegte Daten führen zu (unter-)durchschnittlichen Texten in Relation zum Rest des WWW.

9.1 Text-Bibliotheken und Inhalts-Suche

Der Aufbau umfangreicher Inhalts-Archive beginnt eigentlich mit einer einfachen Entscheidung: "Ab heute wird jeder gute Text systematisch gespeichert".

Die semantische Suche in Text-Beständen ist ein Gamechanger. Statt nach exakten Begriffen zu suchen, findest Du Texte nach Bedeutung und Kontext. "Texte über Vertrauen schaffen" findet auch Artikel über Glaubwürdigkeit, Zuverlässigkeit und Seriosität. Das System versteht dank der Kombination aus einem Sprachmodell und einer Vektordatenbank Zusammenhänge, nicht nur Worte.

Die Wiederverwendung und Anpassung bestehender Texte spart enorm Zeit. Ein gutes KI-System analysiert vorhandene Texte, identifiziert bewährte Strukturen und Formulierungen und adaptiert sie für neue Angebote etc.

Solche Systeme kannst Du mit gut aufbereiteten semantischen und ontologischen Modellen ganz präzise "formen".

Ein praktisches Beispiel: Du hast 100 Produktbeschreibungen für Büromöbel. Das System erkennt: Erfolgreiche Texte beginnen mit dem Kundennutzen, listen dann die Eigenschaften auf und enden mit einem Vertrauens-Signal. Diese Struktur wird zur Vorlage für alle neuen Büromöbel-Texte.

Was dann aber tatsächlich den Unterschied macht, ist z. B. wie die Gründerin den Worten ihre Bedeutung gibt:

Das Holz der Mooreiche: Das ist ein jahrtausendealtes, fossiliertes Eichenholz mit tiefschwarzer Färbung, das Jahrhunderte unter Torfmooren lag. Ohne Sauerstoff verwandelte sich das Holz durch Gerbsäure in ein Material von außergewöhnlicher Härte. Jeder einzelne Stamm ist ein archäologischer Fund. Mit einem Schreibtisch aus diesem Holz "richtest Du nicht einfach ein Büro ein": Du verbindest dich mit einer Kraft, die größer ist als der nächste Quartalsbericht. ;-)

9.2 Markenrichtlinien und Styleguide-Verwaltung

Eine zentrale Verwaltung von Marken-Richtlinien ist kritisch für konsistente Texte. Welche Wörter verwendet die Marke? Welche vermeidet sie? Wie spricht sie über Marktbegleiter? Wie über eigene Schwächen? Diese Regeln müssen für die KI jederzeit abrufbar sein.

Ich regle das über Markdown-Dateien, oft mit eingebetten JSON-Strukturen für die semantischen und ontologischen Referenzen.

Tonalitäts-Vorgaben und Sprachregelungen werden oft unterschätzt. "Professionell, aber freundlich" ist zu vage. Besser: "Wie ein kompetenter Berater, der komplexe Themen verständlich erklärt. Duzt die Kunden, aber bleibt respektvoll. Verwendet Beispiele aus dem Alltag, um abstrakte Konzepte zu erklären."

Konsistenz-Sicherung über alle Website-Texte hinweg ist eine Daueraufgabe. Das System muss erkennen, wenn neue Texte vom etablierten Stil abweichen. Hier sind meine häufigsten Beispiele:

- Wenn plötzlich gesiezt wird, wo normalerweise geduzt wird (oder anders herum).

- Wenn fachliche Begriffe verwendet werden, wo normalerweise Alltagssprache herrscht.

- Wenn die Tonalität nicht zur Marke passt (zu förmlich oder zu lax).

Was ich dabei gelernt habe: Styleguides brauchen dieselbe Lebendigkeit der Unternehmenskultur. Eine PDF-Datei mit Regeln von vor 10 Jahren hilft nicht. Die Richtlinien müssen sich quasi "live" mit der Marke entwickeln, neue Erkenntnisse integrieren, veraltete Regeln streichen. Mit einen guten, KI-unterstützten Prozess können dabei z. B. leicht Inkonsistenzen erkannt werden, mathematisch eingeordnet und in Form von Echtzeit-Dashboards dargestellt werden.

9.3 Inhalts-Verwaltung und Erfolgs-Verfolgung

Bilder, Videos und andere Medien-Integration wird oft vergessen, ist aber wichtig. Texte stehen nicht allein, sondern arbeiten mit anderen Inhalten zusammen. Das System sollte wissen, welche Bilder zu welchen Texten gehören, welche Videos welche Botschaften unterstützen.

Meta-Daten und Inhalts-Kategorisierung machen den Unterschied zwischen Chaos und System:

- Wann wurde der Text erstellt?

- Von welcher KI?

- Für welche Zielgruppe?

- Mit welchem Briefing?

- Wie hat er sich entwickelt?

Ich löse das in manchen Projekten z. B. so, dass jedes Bild und jede Mediendatei eine eigene, spezielle JSON-Datei im System erhält. Das kann in Briefings dann sogar soweit gehen, dass das KI-System den Auftrag bekommt (stark verkürzt): "Erstelle einen Text zum Thema Wandercoaching. Integriere das Portrait von Florian". Das KI-System erkennt auf Basis der Meta-Daten im JSON, wer Florian ist und integriert das jeweilige Portrait.

Und unvermeidbar: Rechteverwaltung und Nutzungsrechte-Verfolgung ist besonders bei größeren Unternehmen wichtig. Wer darf welche Texte verwenden? Wer darf sie anpassen? Wer darf sie veröffentlichen? Gibt es rechtliche Einschränkungen? Das System muss diese Regeln kennen und durchsetzen.

Hier ein bisschen persönliche Meinung: Eigentlich ist es eine große Sauerei, wie die KI-Modelle entstanden sind. Das war ein großer digitaler Raubzug über einfach mal das ganze WWW. Da wurde einfach alles einmal einkassiert. Aber: Ambivalenz allerorten. Ich nutze solche LLMs ja selbst. Aber man kann sich überlegen, wie man sie nutzt: Raspelt man alles bei OpenAI durch oder betreibt man eine lokale Ollama-Instanz mit einem einfachen Sprachmodell und 100% eigener Daten? Ich vermute, da wird es noch einen separaten Beitrag im Lauf der Zeit geben.

Aber zurück zum Thema, noch ein Beispiel aus der Praxis: Das war ein Franchisesystem mit ca. 200 Standorten. Da galt diese Regel: Zentrale Texte dürfen alle verwenden, aber nicht ändern. Lokale Anpassungen sind erlaubt, müssen aber gekennzeichnet werden. Rechtlich sensible Texte dürfen nur von der Zentrale freigegeben werden. Vorbildlich war da: Das System sorgt automatisch für die Einhaltung dieser Regeln, es gab sogar eine regelmäßige Textmustersuche, um Plagiate und modifizierte Texte im WWW aufzuspüren.

Der entscheidende Punkt: Die Datenbanken in diesem Prozess sind keine statischen Archiv, sondern ein lernendes System. Jeder neue Text, jede Erfolgsmessung, jede Optimierung macht sie wertvoller. Nach einem Jahr hast Du so eine einzigartige Wissensbasis, die kein Marktbegleiter kopieren kann!

10. Bedarfsgruppen-Modellierung und Inhalts-Personalisierung

Hier trennt sich die Spreu vom Weizen. Jeder kann allgemeine Texte schreiben lassen. Aber wirklich erfolgreiche Unternehmen sprechen verschiedene Bedarfsgruppen gezielt an. D as Problem: Für jeden Kundentyp andere Texte zu erstellen, war bisher viel zu aufwändig. Mit KI wird das plötzlich machbar.

Was ich immer wieder sehe: Unternehmen haben drei verschiedene Bedarfsgruppen, aber nur einen Einheitstext für alle. Die Geschäftsführung bekommt dieselbe Ansprache wie die IT-Leitung, obwohl beide völlig unterschiedliche Bedürfnisse haben oder Ereignisse erleben. Das ist verschenktes Potenzial.

Gute Personalisierung beginnt nicht mit der Technik, sondern mit dem Verständnis für die Menschen und deren bedarfsauslösende Ereignisse, die Du ansprechen willst. Wer sind sie wirklich? Was beschäftigt sie? Welche Sprache sprechen sie? Was ist ihnen gerade passiert? Erst wenn Du das weißt, kann die KI gezielt für sie schreiben.

10.1 Bedarfsgruppen entwickeln

Hinweis: Zum Thema "Bedarfsgruppen-Modell" habe ich schon einen separaten, ausführlichen Beitrag geplant.

Detaillierte Bedarfsgruppen-Profile für Text-Optimierung gehen weit über "Männer, 35 bis 45 Jahre, mittleres Einkommen" hinaus. Du brauchst Einblicke in ihre täglichen Herausforderungen, ihre Ängste, ihre Hoffnungen, Sehnsüchte. Wie reden sie über ihr Problem? Welche Begriffe verwenden sie? Was überzeugt sie?

Elementar: Die Frage "Was sind die bedarfsauslösenden Ereignisse?"

Sprach- und Tonalitäts-Präferenzen verschiedener Personas sind oft überraschend unterschiedlich:

- Der eine will direkte, praktische Informationen ohne Schnörkel

- Der andere braucht detaillierte, rechtlich abgesicherte Formulierungen

- Der nächste reagiert auf emotionale, visionäre Sprache

Inhalts-Bedürfnisse und Informations-Hierarchien unterscheiden sich teilweise dramatisch. Was der eine als Hauptargument sehen will, interessiert den anderen überhaupt nicht. Preise, Features, Referenzen, Garantien ... die Reihenfolge und Gewichtung muss zur Bedarfsgruppe passen.

10.2 Dynamisierung von Inhalten

Dynamische Text-Anpassung nach Nutzer-Verhalten ist heute technisch soooo leicht machbar. Funktionsprinzip: Das System erkennt, welche Seiten jemand besucht hat, wie lange er verweilt, worauf er klickt. Daraus leitet es ab, welcher Persona-Typ er wahrscheinlich ist und passt die Texte entsprechend an.

Bedarfsgruppen-spezifische Inhalts-Varianten automatisch zu erstellen ist der heilige Gral:

- Fachsprache für Experten

- Alltagssprache für Laien

- Emotionale Ansprache für Entscheider

- Sachliche Darstellung für Analysten

Was dabei oft schief geht: Personalisierung wird zur Verwirrung, wenn sie nicht konsistent durchgezogen wird. Ein personalisierter Einstieg, aber dann wieder Standardtext verwirrt mehr als er hilft. Entweder richtig oder gar nicht.

10.3 Inhalts-Strategie-Entwicklung

Langfristige Inhalts-Planung und -Strategie wird durch KI nicht überflüssig, sondern wichtiger. Du kannst zwar echt schnell echt viele Texte erstellen, aber sie müssen trotzdem ein stimmiges Gesamtbild ergeben. Welche Botschaft soll über alle Kanäle hinweg ankommen?

Redaktionskalender und Inhalts-Fahrpläne bekommen eine neue Dimension. Du planst nicht mehr nur "Wann erscheint welcher Text?", sondern "Welche Bedarfsgruppe bekommt wann welche Botschaft auf welchem Kanal?" Das wird komplexer, aber auch viel gezielter.

ROI-Messung und Inhalts-Erfolgs-Kennzahlen müssen Bedarfsgruppen-spezifisch gedacht werden:

- Text für Geschäftsführer ist erfolgreich, wenn er zu Beratungsterminen führt

- Text für IT-Leiter ist erfolgreich, wenn er zu kostenlosen Tests führt

- Text für Endkunden ist erfolgreich, wenn er zu direkten Käufen führt

Meine Erfahrung: Die besten Ergebnisse erzielst Du, wenn Du mit zwei, drei Ereignissen einer Bedarfsgruppe anfängst und sie gut ausarbeitest, bevor Du die nächste angehst. Drei mittelmäßige Dynamisierungen sind schlechter als eine pragmatisch Funktionale.